一个正常人,闭着眼睛行走,也会走歪。

我们通常也会走神,当我们意识到时,便会猛然纠正。

以上两个例子,一个是失去U时的状态,一个是找回U时的反馈。

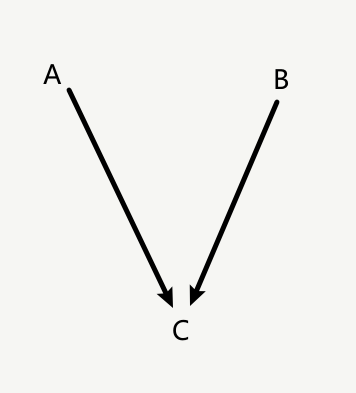

考虑一个因果推理中的简单例子:

A→C←B 当C处于临界态的时候,Pc((+|A,B)) ≈Pc((-|A,B))

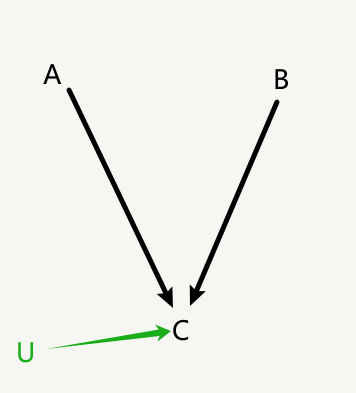

此时引入U,使得Pc((+|A,B,U)) >>Pc((-|A,B,U))或者Pc((+|A,B,U)) <<Pc((-|A,B,U))

U自身的特征主要有两个要求:提高了信息熵,或者提高了信噪比。

- 信息熵的提升,在于引入额外的区分度,从而更好地适用选择公理。

- 信噪比则是如MLA或者高阶表征所做的,从噪音中提取了更关键的信息。

在实际情况中,两点往往会不加区分混合适用,原因是某些结构的方式有效,但是为什么有效没有进行区分。

U的来源和形式多种多样,例如:

- RNN → Transformer,在RNN中,每次的输入是xt和ht,输出的目标是yt。但是ht是每次都会随着训练不断变化的,这是否会导致从ht学到的东西很困难。而Transformer通过展开更多的确定性的信息,使得其作为相对于RNN的模型提供了更多的U,提高了模型性能。

- CoT和ToT通过生成时间上展开和空间上展开的类世界模型建模,来提高信噪比和利用既有的信息熵,收集U。

- Yann的世界模型中,通过JEPA生成高阶表征,对世界建模利用信噪比提升后的表征而非原始像素来预测下一帧,提供预测信息和模拟运动的反馈来收集U。

- Deepseek V3中的GRPO 通过生成大量的轨迹,并引用一致性和强化学习来收集U,并将U再次进行训练更新模型权重。

- 李飞飞的空间计算,增加了U的多模态,模态交叉能大大提高信噪比,防止上面举例的AB对C造成的临界情况Pc(+|A,B) ≈Pc(-|A,B)。

所以我们往往会说从CoT开始,LLMs已经有了自己的世界模型。而Transformer相对于RNN本质上也是通过信息损失更少的编码方式提供了更优质的U。

回到这个公式:

在P((x|X, U))>>P((x|X)) 中,X代表一个序列,x代表下一步要输出的内容。U可以由X独立生成比如CoT、GRPO或者不与真实世界交互的世界模型通过粗粒化、一致性等提高信噪比;也可以由外部干预和X整合生成比如RLHF与真实世界交互的世界模型具身反馈获得额外信息熵。

'>>'则表示,通过U的引入,可以得到更加具有确定性的x输出。无论这种确定性是来自自我想象能够自然产生意识和自我意识运动的世界模型又或者是自然选择的自指循环Loop的弧形片段的两端。

在未来,我们需要从以下几个方面提升U的生成:

- U的及时反馈性,在线学习,自动提高信噪比和收集信息熵。建模和内化新皮质自带的好奇心。TokenFormer是一个很不错的方向,和MoE的思想相辅相成。

- 内部U的动态更新,除了利用GRPO和RLHF这种展开世界模型从反馈中学习的方式,通过结合空间计算的具身智能让Agent自主探索环境,并利用增量学习将推理和训练合二为一。将来的模型训练和推理的边界将会十分模糊而融合。

- 世界模型和多模态生成的固定通用高阶表征将成为U扩展的脚手架,全球参与者可以共同训练同一个模型,并基于该“脚手架”为该模型共同添砖加瓦,去中心化的贡献协议或许在这里可以发挥作用。固定通用的高阶表征作为“脚手架”打通符号主义和连接主义,马文明斯基此时的框架模型才开始发力。

最后一次更新于2025-02-15

0 条评论